Одной из самых распространенных проблем в SEO является выпадение из индекса страниц сайта. Это отрицательно сказывается на его видимости и влечет массу других неприятных последствий, например, снижает позиции сайта и уменьшает количество потенциальных клиентов, предпочитая конкурентов.

В этой статье мы подробно рассмотрим основные причины деиндексации – от низкокачественного контента и проблем с внутренней структурой до технических ошибок и обновлений алгоритмов Google. Материал будет полезен владельцам сайтов и специалистам, желающим эффективно выявлять и устранять причины неполадок.

Важность качественной индексации для SEO-продвижения проекта

Проблемы с индексацией сайта и успешное SEO-продвижение – несовместимые понятия. Поэтому, если вы хотите развиваться, занимать ведущие позиции в выдаче и увеличивать прибыль, важно постоянно отслеживать индексацию, особенно если у вас сайт не на 3 страницы. Невозможно иметь хорошие позиции у страницы, если она не проиндексирована в Google, в таком случае даже самый продуманный и удобный веб-ресурс может остаться незамеченным потенциальной аудиторией. Перечислим основные причины, объясняющие важность индексации:

- Видимость в Google – поисковый бот рассчитывает позиции в поисковой выдаче исключительно тем страницам, которые есть в индексе; если страницы в индексе нет, то позиций и трафика по поиску у нее быть не может.

- Влияние на позиции сайта – в случае объемных сайтов, чем больше у вас полезных страниц в индексе, имеющих ссылки на другие страницы, тем легче продвигается сайт, в целом, потому что страницы передают внутренний вес ссылок друг на друга.

- Влияние на объем трафика – чем больше полезных страниц в индексе у сайта, тем больше точек входа пользователя и, как следствие, потенциального трафика.

- Влияние на показатели качества проекта – обычно проблемы с индексацией появляются, если на сайте есть технические ошибки, спамный контент и другие моменты, не нравящиеся поисковым системам; чем больше на веб-ресурсе проблем с индексацией, тем больше он имеет негативных маркеров для Google и других поисковиков, и тем хуже будут продвигаться даже проиндексированные страницы.

Как проверить индексацию сайта в Google

Улучшить индексацию сайта важно не только для ускорения появления страниц в поиске, но и для контроля уже проиндексированных материалов. Один из первых шагов для успешного продвижения – проверить, как поисковая система видит ваш ресурс и его отдельные страницы. В Google это можно сделать несколькими способами:

- Через поисковый оператор "site:" – для этого в поисковой строке введите "site:example.com", в результатах поиска вы увидите количество проиндексированных страниц.

- Через Google Search Console (GSC) – после добавления сайта перейдите в блок «Покрытие» или «Индексирование», где будет видно количество проиндексированных и исключенных страниц, также можно подать запрос на индексацию отдельных URL.

- Дополнительные SEO-инструменты – среди разнообразия сервисов для выявления реальной ситуации с индексацией наиболее популярными считаются Ahrefs, RocketCrawler, SiteAnalyzer.

- С помощью букмарклетов – это мини-скрипты, закрепленные в закладках, которые позволяют быстро проверять индексированность текущей страницы одним кликом.

Почему Google выбрасывает страницы из индекса

Когда падает индексация сайта, вы сталкиваетесь с коварной проблемой, ведь обычно это происходит тихо и незаметно, без каких-либо предупреждений со стороны системы. Еще одной особенностью, усложняющей процесс, является необходимость выявления причин. Даже если вы заметили отсутствие учета страниц в поиске, необходимо найти причину, а это уже требует профессионализма, опыта и глубоких знаний. SEO-специалист должен изучить проблему, проанализировать факторы, предшествующие падению индексации, затем выстроить гипотезу, проверить ее и предложить возможные пути решения. Ниже перечислены наиболее распространенные причины, почему страницы выбрасывает из индекса.

Проблемы с контентом и структурой сайта

Если такие базовые элементы сайта, как структура и контент, недоработаны и некачественны, высока вероятность выпадения страниц из индекса. Поисковые системы все строже оценивают внутреннее наполнение ресурсов, пользу и актуальность контента, логику переходов между страницами, общее удобство навигации. Страницы без ценности, дубли, слабое пересказывание – все это мешает поисковикам понять, какие разделы важны, многое он считает малозначимым и выбрасывает из индекса. Чтобы улучшить индексацию, сохранить видимость и позиции, важно регулярно проводить аудит контента и структуры.

Контент и страницы низкого качества

Очень частой причиной выпадения из индекса является низкокачественный контент. Поисковые системы ценят уникальность, полезность, экспертность, информативность пользовательского контента. Отклоняясь от этих принципов, вы рискуете потерять столь важную индексацию страниц. К примеру, на сайте размещены статьи, написанные не человеком, а сгенерированные AI без вычитки и просто под ключевой запрос, или нарезанные из разных источников конкурентов и объединенные в одну статью, и максимально провальный вариант – обычный копипаст чужих работ.

Бывают такие ситуации, когда на сайт добавляется подобный низкопробный контент, но индексация не прекращается мгновенно. Могут пройти месяцы до очередного обновления алгоритмов, пока поисковые роботы обнаружат эти тексты, наберется критическая масса замечаний у Google к сайту и поисковые системы начнут исключать страницы из индекса. Поэтому для глубокого анализа проблемы следует учитывать довольно продолжительный предыдущий период.

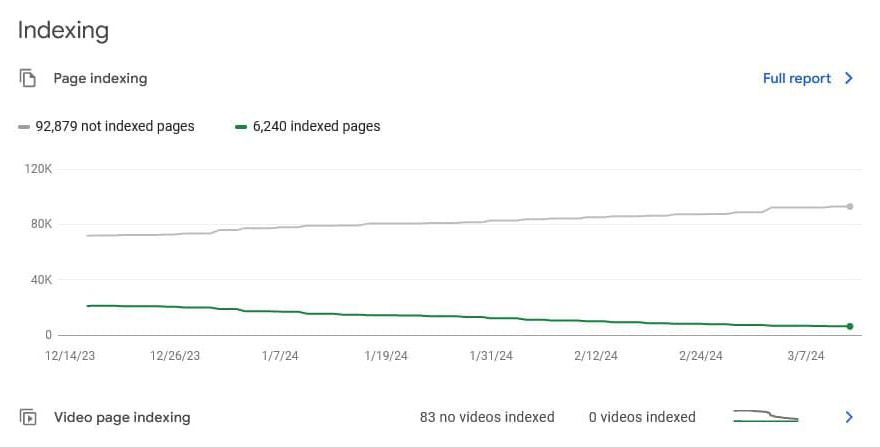

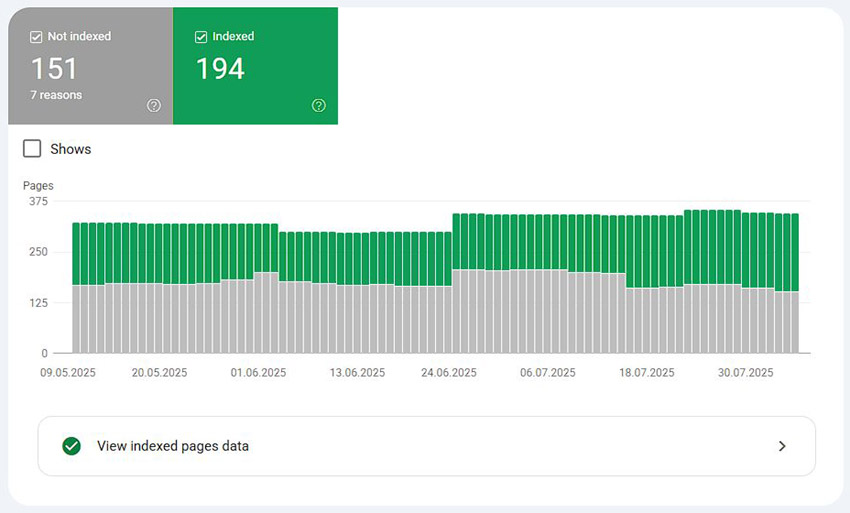

Сайт, у которого происходит постепенное выпадение страниц из индекса из-за их низкого качества, по всей видимости, это длится не один день

Также распространенной причиной деиндексации становятся некачественные страницы в целом. Это могут быть, например, пустые и полупустые страницы без товаров и контента. Если специалисты относятся безответственно к заполнению сайта, генерируют с помощью нейросети буквально все даже без вычитки, создают массу дублей или просто делают свою работу некачественно, то рано или поздно боты заметят это и сочтут бесполезным, а значит, исключат из индекса.

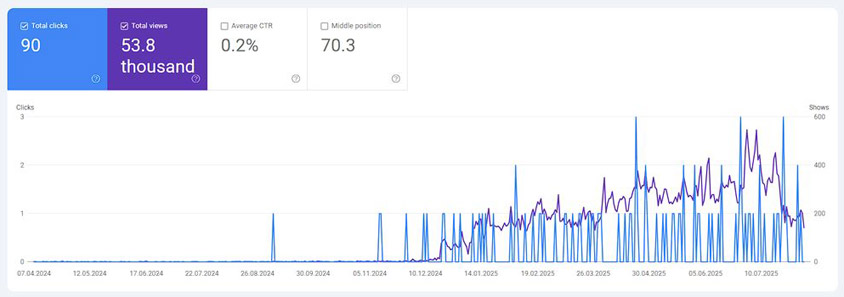

Возврат трафика сайта после замены полностью ИИ-сгенерированного низкокачественного контента на нормальный и полезный

Для улучшения ситуации нужно заняться серьезной оптимизацией контента. Любой контент на сайте должен быть грамотным и качественным, нести ценную пользовательскую информацию и не содержать ошибок. Поэтому доработайте имеющиеся страницы, дав задачу опытному копирайтеру, переработайте, удалите или скройте неактуальный и устаревший контент. Важный момент: проследите, чтобы контент, в первую очередь, был полезен пользователям и давал ответы на их вопросы, а не писался просто для SEO.

Недостаточное внутреннее переубеждение

Внутренняя перелинковка, кроме положительного влияния на пользовательский опыт, играет важную роль для индексации: она помогает поисковым системам определить приоритетные страницы и важность тех или иных страниц для сайта в целом. Не работающие ссылки или страницы, на которые не ведут внутренние ссылки, затрудняют поиск и понимание вашего сайта поисковыми системами. Если у страницы нет входящих ссылок с других проиндексированных страниц или их мало, Google может расценить ее как малозначимую или Orphan page и со временем исключить из индекса. Подобные проблемы могут возникать в следующих случаях:

- При добавлении новых страниц без их интеграции в основное меню.

- При массовом добавлении новых страниц на сайт, например товаров или статей, когда пагинация категорий, которая должна распределять вес по этим страницам, закрыта от индексации.

- В ситуации, когда страницы доступны только по прямой ссылке, но не связаны с другими материалами.

Пример сайта услуг с блогом с преимущественно уникальным контентом, но проблемной индексацией из-за некорректно реализованной перелинковки и структуры в проекте (страницы вручную пробовали отправлять в индекс, но через пару дней они вылетали).

Простейшим решением будет добавление на сайт блоков перелинковки, например, «Похожие товары», «Рекомендуемые статьи», «С этим также покупают» – это создаст естественные ссылки между страницами, улучшит навигацию и перераспределит внутренний вес ссылок на более глубокие страницы сайта, которые обычно ее не получают. Также вы можете вручную проставить ссылки из релевантных статей, категорий или блоговых материалов. И, конечно, не стоит забывать о необходимости проверки сайта (меню, фильтры, хлебные крошки и т.п.) и Sitemap.xml.

Технические причины

Технические ошибки часто становятся скрытым источником проблем с индексацией: даже если контент и структура сайта отвечают требованиям SEO, некорректные настройки могут полностью или частично закрыть ресурс от поисковых систем. Особенно это актуально во время редизайна, переноса сайта на новый домен или обновление движка. Важно проверять такие параметры до публикации, чтобы не потерять странички из индекса и не обнулить результаты продвижения.

Запреты на индексацию – случайны или из-за взлома сайта

Такое часто происходит при обновлении сайта. Например, когда загружают финальную версию с тестового сервера, разработчики могут забыть убрать настройки, запрещающие индексацию. Чтобы не выпасть из индекса, такие настройки обязательно следует проверять перед публикацией обновлений. Перечислим подробнее, какие ошибочные настройки могут встречаться:

- Директива Disallow в файле Robots.txt – закрывает определенные разделы или весь сайт от сканирования.

- Метатег meta name="robots" content="noindex" – указывает поисковику не добавлять страницу в индекс.

- HTTP-заголовок X-Robots-Tag: noindex – аналог метатега, но задается на уровне сервера.

- Парольная защита или ограничение по IP – иногда тестовую версию закрывают паролем, а при переносе на рабочий домен забывают снять ограничения, из-за чего поисковики видят только главную страницу.

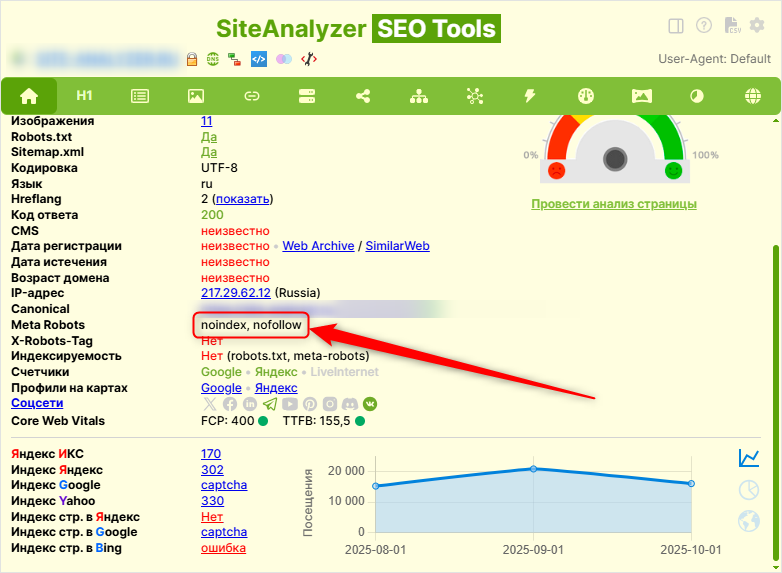

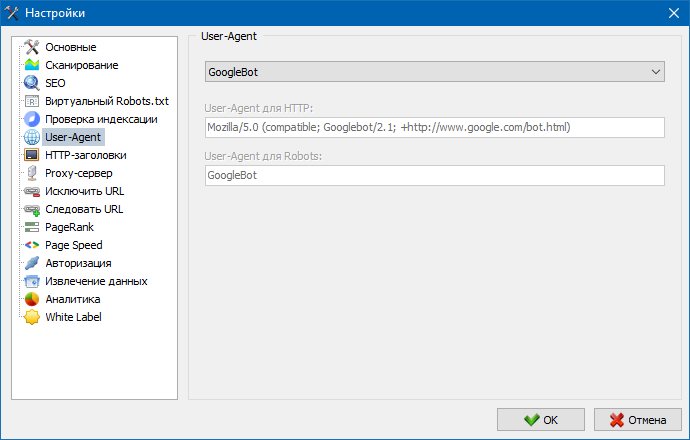

Еще одну проблему продемонстрируем на любопытном примере. Нашей целью было выяснить, почему Google выбрасывает из индекса полезные страницы услуг. Проблема заключалась в том, что сканер Google показывал запрещение страницы для индексации, но фактически, когда мы открывали ее из браузера, проблем с индексацией не было. Для уяснения источника происхождения этой команды было построено несколько предположений. Возможно, Noindex стоит только для Google бота или, например, для определенных IP, из которых входит бот. Чтобы проверить гипотезу, мы использовали программу SiteAnalyzer. В настройках пользователя-агента вместо стандартного сканера выставили GoogleBot Smartphone или GoogleBot Desktop. Оказалось, что для пользователей Google эти страницы действительно содержали теги noindex.

Так выглядят настройки правил User-Agent для сканера SiteAnalyzer

Клиент, у которого в результате взлома был проставлен тег Noindex для Google бота

Начав поиск причин, выяснилось, что в прошлом был взлом на клиентском проекте из-за SEO-плагина. Взломщики сделали закрытие от индексации страницы только для пользователя-агента Google, а для всех остальных – специально не закрывали, чтобы усложнить и затянуть процесс обнаружения взлома. После удаления вредоносного кода ситуация нормализовалась: страницы вернулись в индекс и поисковая система снова начала корректно работать с сайтом. Данный кейс показывает, что запреты на индексацию могут быть как явными (Robots.txt, Meta Noindex), так и скрытыми (выборочный noindex для ботов, определенных IP и т.п.). Поэтому важно регулярно проверять сайт исходя из разных идей, включая поведение поисковых агентов.

Дубли страниц

К снижению рейтинга и потере трафика может приводить наличие одинакового или схожего контента на нескольких страницах. В таком случае поисковые работы не могут определить, какие страницы более авторитетны и релевантны конкретному поисковому запросу. К тому же из-за создания дублей поисковая система может заподозрить вас в манипуляциях результатами SERP и полностью удалить из поискового индекса. Что можно сделать, если схожие страницы вам все же нужны и вариант удаления не рассматривается:

- Использовать тег "rel=canonical" в блоке HEAD.

- Настроить редирект 301 со страницы-дубля на каноническую страницу.

- Сделать все подобные странички уникальными, изменить метатеги, описания, фото и прочее.

Непродуманная смена URL (ЧПУ – человек понятные урл)

Изменение структуры URL постоянно сопровождается выпадением из индекса. Это закономерный процесс, который вряд ли удастся обойти, но его можно ускорить. Для процесса смены урлов нужно, чтобы старая страница выпала из индекса, а новая зашла. И не всегда эти моменты происходят параллельно. В одном проекте во время смены ЧПУ количество неиндексированных страниц возросло с 87 до 153, а количество проиндексированных — со 193 до 250. Это означает, что одни страницы выпали, другие заменили их.

Пример такого случая – у клиента была полностью перестроена логика формирования урлов и настроены редиректы, но при этом при подаче на индексацию обновленных урлов росло количество неиндексированных и проиндексированных страниц.

Похожая ситуация у другого клиента – здесь была изменена структура формирования URL-адресов, но при этом редирект никто сразу не настроил, поэтому учет новых страниц шел гораздо дольше по мере настройки редиректов.

Основные причины таких проблем:

- Отсутствие или некорректная настройка редиректов 301.

- Появление ошибки 404 на старых или новых страницах.

- Циклы перенаправления (Redirect Loop), спровоцированные опечатками или ошибками в .htaccess.

- Изменения CMS, настроек сервера или структуры папок, затрагивающих URL-адреса.

К сожалению, в случае изменения URL избежать их переиндексации и выпадения старых вариантов из индекса невозможно. Это влечет и временное проседание сайта на несколько недель или месяцев. Поэтому если есть необходимость внедрения новых адресов страниц, желательно делать это как можно раньше, пока сайт еще новый, не слишком большой и не успел выйти на высокие позиции – тогда проседание будет менее заметным. И самое важное – необходимо настроить редиректы 301 из старых адресов на новые. Только такой алгоритм действий позволит сделать переход на новый формат URL менее болезненным.

После настройки редиректов на новые адреса рекомендуется проверить их работу через RocketCrawler или аналогичный сканер. Это поможет выявить ошибки 404 и циклические редиректы. Также важно заменить временные редиректы 302 на постоянные 301, чтобы поисковые системы быстрее обновили свои данные с учетом новых урлов.

После внесения изменений в структуру URL или настройки редиректов полезно повторно индексировать страницы сайта через инструмент «Проверка URL» в Google Search Console. Чтобы сэкономить время и ресурсы можно отправлять не все страницы подряд, а наиболее ключевые, и из них бот дальше будет переходить на другие страницы самостоятельно. Благодаря этой функции можно точно знать, попала ли нужная страница в индекс. Только имейте в виду, что процесс переиндексации может занять несколько дней или недель, поэтому результаты следует оценивать не сразу, а через некоторое время.

Другие возможные причины

Кроме технических и контентных факторов, на индексацию сайта могут влиять и другие причины, которые необходимо учитывать при комплексном SEO-анализе. В этой статье мы рассматриваем самые распространенные причины, ведь их общее количество действительно огромно. К сожалению, некоторые специалисты не углубляются в сущность и особенности бизнеса, а просто применяют стандартные подходы. В результате поиск проблем и проверка гипотез затягивается на долгие месяцы, что негативно сказывается на видимости сайта в выдаче. Важно понимать, что поисковики постоянно изменяют правила игры, а неудачные решения, такие как чрезмерное количество исходящих ссылок, могут негативно повлиять на восприятие сайта. В следующих разделах рассмотрим это подробнее.

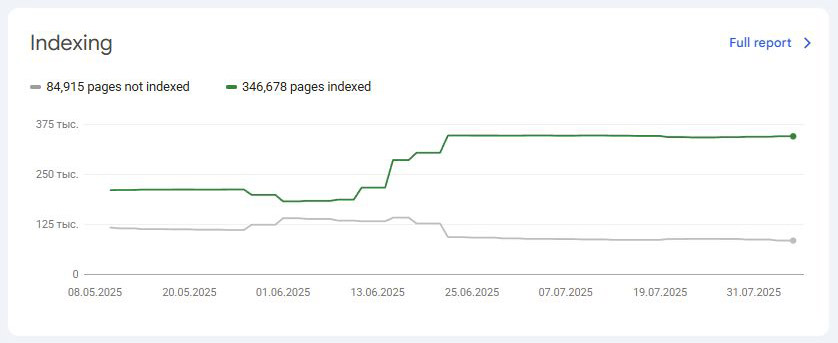

Обновление алгоритмов Google

Одна из самых частых причин выпадения из индекса – обновление алгоритмов Google и правил оценки качества контента, ведь система постоянно совершенствуется. Если очередным таким обновлением стал подход к оценке качества контента, то есть риск того, что некоторые страницы начнут деиндексироваться. Один из наших кейсов – яркий тому пример. В какой-то момент на сайте клиента перестала индексироваться сначала одна группа страниц, затем следующая, хотя до этого все было стабильно. В нашем случае Google (после очередного апдейта) считал многие страницы низкокачественными из-за того, что на них было мало внутренних ссылок или их не было совсем. После внедрения блока «Похожие товары» индексация была восстановлена, более того, даже улучшена.

На сайте товарные карточки недополучили внутренний вес, поскольку пагинация на категориях была закрыта от индексации и Google стал выбрасывать их из индекса. Внедрение блока «Похожие товары» на страницах переломило эту ситуацию.

Множество исходящих ссылок

Такая проблема часто встречается на сайтах, продающих ссылки. У них больше исходящих ссылок, чем наоборот. Для поисковой системы это признак низкокачественного ресурса, или созданного специально под ссылку, а значит, не несущего никакой пользы. Контент таких статей часто очень слаб. Обычно выпадение из индекса возрастает по мере увеличения количества размещенных таким образом статей. Поэтому рекомендуем не злоупотреблять размещением низкокачественных статей с исходными ссылками на другие ресурсы и наполнять сайт качественным контентом для баланса. В противном случае будет наблюдаться плавное падение трафика и выпадение страниц из индекса.

Как избежать проблем с индексацией

Качественная индексация – основа успешного SEO и стабильного продвижения. Для сохранения позиций важно не просто решать проблемы по мере их возникновения, но и предотвращать их. Для этого необходимо регулярно контролировать состояние сайта, структуру и технические настройки, обращать внимание на качество контента и его актуальность. Ошибки URL, плохая перелинковка, низкая уникальность и качество контента, дубли и запреты на индексацию способны серьезно навредить видимости, поставив на стоп ваш органический рост. Постоянно анализируйте веб-ресурс, применяйте актуальные инструменты и своевременно исправляйте ошибки – это поможет избежать потери страниц и сохранить доверие поисковых систем.

Оригинал материала от Оксана Артюшенко

Другие статьи

118

118